Das Beispielprogramm Wort-Navigator

Der Wort-Navigator überträgt Beziehungen zwischen Wörtern

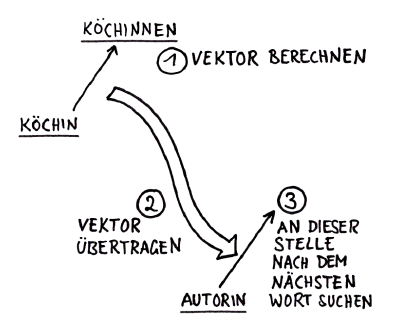

Im Programm Wort-Navigator könnt ihr einfache Worteinbettungen inspizieren und Beziehungen zwischen zwei Wörtern ermitteln und auf ein anderes Wort übertragen, wie das folgende Bild zeigt. Wenn alles richtig gelaufen ist, sollte das Wort Autorinnen gefunden werden:

Im Wort-Navigator sieht das dann so aus. (Die Winkel der Vektoren stimmen übrigens nicht überein, weil der Einbettungsraum in diesem Fall 30 Dimensionen hat. Bei der Reduzierung auf 2 Dimensionen geht die Winkeltreue verloren):

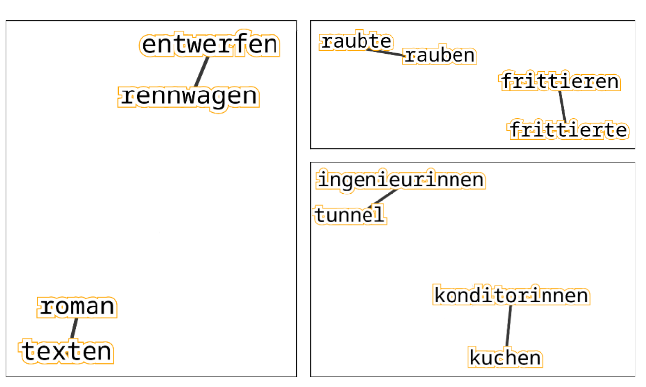

Weitere gelungene Übertragungen aus dem Wort-Navigator:

Hier ist ein Screenshot des kompletten Wort-Navigators:

PROGRAMM STARTEN

Demo Video

Achtung: Aus unerfindlichen Gründen laufen viele in Moodle eingebettete Videos nicht unter Firefox. Falls ihr Firefox nutzt, solltet ihr einen anderen Browser nutzen, um die Videos zu schauen.

Sätze, anhand derer diese Worteinbettung trainiert wurde

ein koch kocht jetzt schonend die soße

zwei musikfreunde proben jetzt pfeifend den song

fünf diebinnen raubten letztens dreist einen tresor

ein autor textet gerade hochkonzentriert ein anschreiben

zwei köche kochen gerade schonend die soße

eine diebin raubt jetzt rücksichtslos den geldkoffer

ein autor schrieb neulich wortgewandt eine kurzgeschichte

eine kunstfreundin zeichnete neulich kunstvoll das blumenmuster

vier köche kochten neulich schonend eine suppe

drei diebinnen raubten gestern dreist einen tresor

ein koch brät gerade schonend das omlette

eine konditorin frittierte vorhin kalorienreich einen krapfen

ein nerd 3D-druckt gerade pedantisch das ersatzteil

zwei köche dünsten gerade schonend einen rosenkohl

ein ingenieur plante neulich normgerecht einen tunnel

drei maurergesellinnen verputzen nun fachgerecht die wand

drei köche brieten letztens lecker das omlette

vier nerds löteten vorhin akribisch das flausch-o-meter

eine autorin schreibt derzeit wortgewaltig den roman

vier musikfreunde spielten neulich hochmusikalisch die rock-oper

vier maurergesellen bauten gestern fachgerecht das haus

drei maurergesellen bauten vorhin gründlich eine garage

vier ingenieure konstruierten neulich sachverständig einen rennwagen

vier maurergesellinnen mauern derzeit geschickt eine brandmauer

vier ingenieurinnen planen nun sachgerecht eine brücke

drei musikfreunde spielten gestern hochmusikalisch eine rock-oper

vier maurergesellinnen bauen jetzt geschickt einen türsturz

vier diebe stahlen neulich frech die krone

vier musikfreundinnen komponieren derzeit pfeifend eine klaviersonate

zwei konditoren garnierten vorhin verführerisch eine praline

ein dieb klaut gerade frech die banane

fünf maurergesellinnen bauen derzeit gründlich einen türsturz

eine köchin kocht nun schonend die soße

drei autorinnen dichteten letztens wortgewandt das haiku

eine autorin schreibt gerade wortgewandt die kurzgeschichte

ein kunstfreund gestaltete letztens kunstvoll den entwurf

ein dieb klaute gestern frech eine banane

ein musikfreund spielte gestern hochmusikalisch eine matinee

Alle 15.552 Sätze findet ihr hier: http://www.maschinennah.de/wp-content/uploads/2024/06/zeilen-2.txt

Wie wurde die Worteinbettungen trainiert?

Es sprengt den Rahmen dieses Kurses, hier zu erklären, wie das Trainieren einer Worteinbettung funktioniert. Wenn ihr es genau wissen wollt, könnt ihr das in meinem Buch ab Seite 282 nachlesen.

An dieser Stelle reicht uns eine stark vereinfachte Erklärung:

Zunächst werden unsere Wörter durchnummeriert.Die Nummern sind vollkommen beliebig, sie haben nichts mit der Bedeutung zu tun.

Und dann trainieren wir ein künstliches neuronales Netz darauf, sozusagen, Lückentexte auszufüllen. Das heißt, wir nehmen immer einen Ausschnitt aus unseren Beispielsätzen, und lassen ein Wort weg:

eine autorin ______ gerade wortgewandt die kurzgeschichte

vier ingenieurinnen planen nun ______ eine brücke

zwei köche dünsten ______ schonend einen rosenkohl

Das künstliche neuronale Netz wird darauf trainiert, für jede dieser Lücken das passende Wort zu finden. Auch hier gilt, dass es nicht eine richtige Lösung gibt, sondern für jedes Wort aus unserem Vokabular eine Wahrscheinlichkeit zu berechnen. Etwa so:

vier ingenieurinnen planen nun ______ eine brücke

0: sachgerecht

1: normgerecht

2: sachverständig

...

Um dieses Problem zu lösen, findet das künstliche neuronale Netz gewissermaßen die Worteinbettung. Mehr dazu wie gesagt im Buch!